Существует ряд причин, по которым может потребоваться закрыть сайт от индексации в поисковых системах. Например, он находится в разработке, выбранный домен является копией основного или что-то еще. В этой статье будут разобраны основные методики, позволяющие скрыть отдельную страницу или весь сайт от индексации поисковыми системами.

Способы запрета индексации сайта

Итак, основные варианты запретить поисковым системам индексировать ваш сайт или определенные страницы это:

- Прописать запрещающие директивы в файле robots.txt.

- Прописать на страницах сайта запрещающий к индексации мета-тег robots.

- Через заголовок X-Robots-Tag.

- Использовать авторизацию на сайте.

- Изменить настройки сервера.

- Изменить ответ сервера.

- Закрыть сайт через настройки CMS.

Разберем каждый метод более подробно.

Файл robots.txt

С помощью этого файла можно указать поисковым роботам отдельные инструкции по индексации. Чтобы скрыть весь сайт от индексации для всех поисковых систем файл должен иметь следующее содержимое:

User-agent: *

Disallow: /

Когда нужно скрыть сайт от индексации в Яндекс, следует прописать следующее:

User-agent: Yandex

Disallow: /

Для скрытия от индексации в Google пропишите следующее:

User-agent: Google

Disallow: /

Также с помощью этого файла можно закрыть от индексации отдельную страницу сайта, прописав:

Disallow: /sotsialnye-seti$

Где sotsialnye-seti – это адрес страницы вашего сайта без указания домена. Указанная в примере директива закроет от индексации страницу https://vsetyrabota.ru/sotsialnye-seti. Если необходимо закрыть не только саму страницу, но и все URL, которые входят в указанный раздел, в файле robots.txt необходима следующая строчка:

Disallow: /sotsialnye-seti

В результате будет закрыта от индексации страница https://vsetyrabota.ru/sotsialnye-seti и все страницы внутри нее, например:

https://vsetyrabota.ru/sotsialnye-seti/218-kupit-akkaunt-vkontakte

Данный способ является одним из самых простых и рекомендуется к использованию поисковыми системами. Директива Disallow позволяет запретить индексацию как конкретной страницы, так и целого раздела, группы файлов или всего сайта.

Использование мета-тега robots

Не стоит путать тег robots и файл robots.txt. Тег прописывается в коде страницы, а файл располагается в корневой папке домена.

Для запрета индексации страницы, в коде между блоками <head> и </head> следует прописать значение noindex или none. Выглядеть такой код будет следующим образом:

<meta name=”robots” content=”noindex”/>

Или

<meta name=”robots” content=”none”/>

Указанные выше теги срабатывают на обе поисковые системы. Если нужно запретить индексацию страницы в одной поисковой системе, следует прописать следующее:

Для Google:

<meta name="googlebot" content="noindex">

Для Яндекса:

<meta name="yandex" content="none" />

- Директива noindex – запрещает индексацию страницы, и она не будет участвовать в результатах поиска;

- Директива none – соответствует директивам noindex, nofollow – страница запрещена от индексации, и она не участвует в результатах поиска, а также поисковому роботу дано указание не переходить по ссылкам на странице.

Использование заголовка X-Robots-Tag

Принцип работы заголовка X-Robots-Tag, аналогичен мета-тегу robots. Однако его действие распространяется на все виды контента, которые расположены на сайте, поэтому можно считать его более надежным (хотя и мета-тег robots прекрасно справляется со своей задачей).

Для запрета индексации страницы сайта, следует использовать те же директивы, что и для тега robots: noindex или none. Пример использования заголовка:

X-Robots-Tag: noindex, nofollow

Авторизация на сайте

Указанные выше способы не всегда позволяют скрыть все страницы сайта от индексации. Особенно это актуально для главной страницы. В официальном руководстве Яндекса говорится, что при наличии ссылок на главную страницу – есть вероятность сохранения ее в индексе поисковых систем. Чтобы решить проблему, дополнительно настраивают авторизацию при переходе на эту страницу.

Смена настроек сервера

Радикальный метод, который позволяет изменить настройки обращения к серверу для роботов поисковых систем. Для внесения правок потребуется изменить данные в файле .htaccess. Обычно к такой проблеме прибегают в том случае, когда поисковые боты продолжают индексировать сайт не смотря на все проведенные действия. Чтобы запретить им это делать в файле прописывают следующие строчки:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot

SetEnvIfNoCase User-Agent "^Yandex" search_bot

Первая строчка запретит доступ поисковому боту Google, а вторая Яндексу. В результате страницы должны вылететь из индекса.

Смена ответа сервера страницы

Как известно, для индексации страницы она должна иметь 200-й ответ сервера. Соответственно при изменении ответа на 30Х или 40Х – страница со временем выпадет из индекса поисковых систем. Назвать это способом запрета страницы от индексации довольно сложно, да и поисковики могут длительное время сохранять страницу с отличным от 200-го ответом сервера в выдаче. Однако чаще всего такие странички выпадают из индекса в течении одного или нескольких обходов. Не рекомендуется использовать этот метод для скрытия страниц от индексации.

Использование настроек CMS

Любая популярная CMS имеет в «коробке» возможность скрыть сайт от индексации для поисковых систем. Достаточно лишь установить галочку или задать соответствующую настройку, а система все сделает за вас.

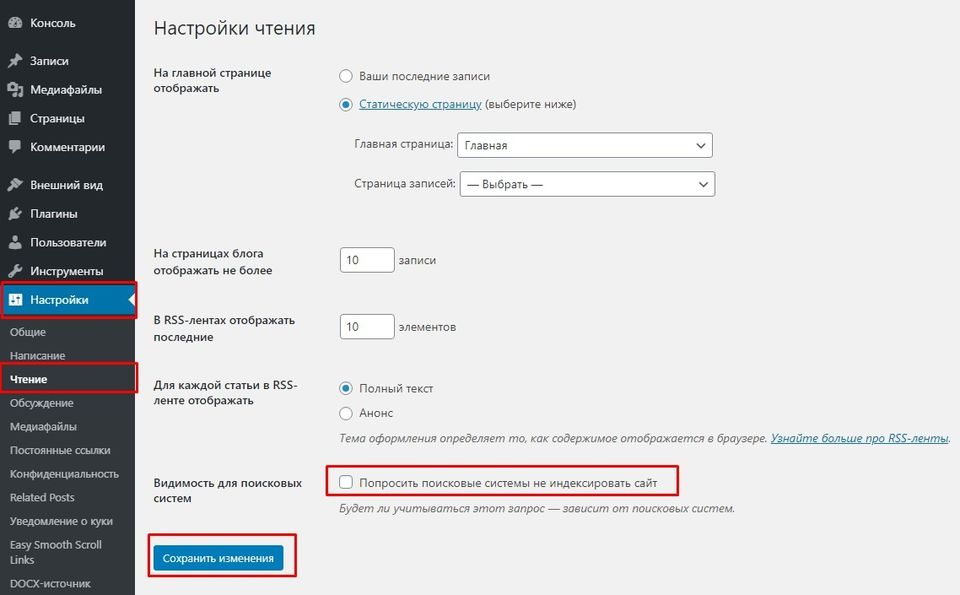

На WordPress сделать это можно через панель администратора. Заходим в раздел «Настройки» => «Чтение» и устанавливаем галочку напротив соответствующего блока. Не забудьте сохранить изменения.

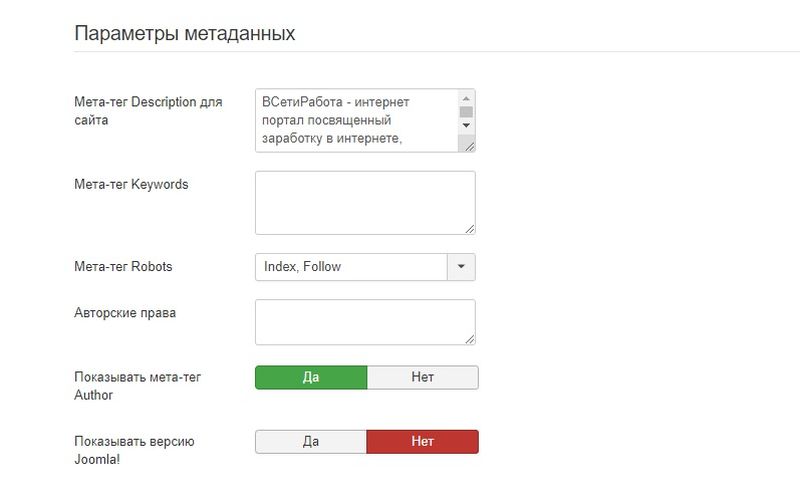

На Joomla вы это можете сделать в разделе «Общие настройки» => «Сайт». Нас интересует вкладка «Параметры метаданных» и у блока Мета-тег Robots устанавливаем значение «No index, No follow». Стоит обратить внимание, что если у отдельного материала в настройках будет прописан отличный от этого мета-тег, то работать будет именно он.

Дополнительно на многие сайты распространяются плагины для SEO-оптимизации. Некоторые из них предусматривают возможность устанавливать настройки по индексации страниц.

Как проверить, что страница запрещена к индексации?

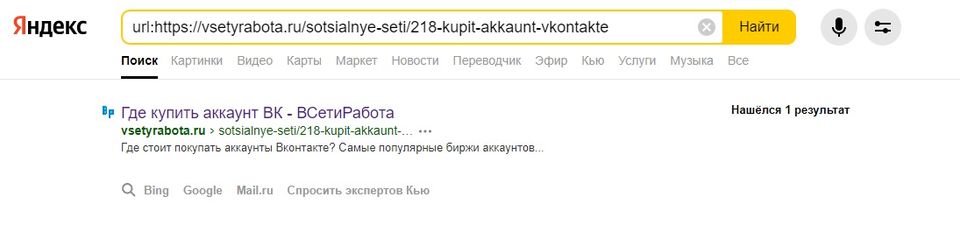

Выбрав указанный способ и запретив индексацию сайта или его страницы, необходимо проверить, правильность выполненных действий. Узнать находится ли сейчас страница в индексе можно вручную, используя поисковый оператор url для Яндекса. Например:

url: https://vsetyrabota.ru/sotsialnye-seti/218-kupit-akkaunt-vkontakte

Вбив этот оператор в поисковую строку, вы увидите присутствует ли страница в индексе:

В Google раньше использовался оператор info, аналогичный оператору url для Яндекса, но в 2019 году было официально объявлено о том, что это оператор отключат.

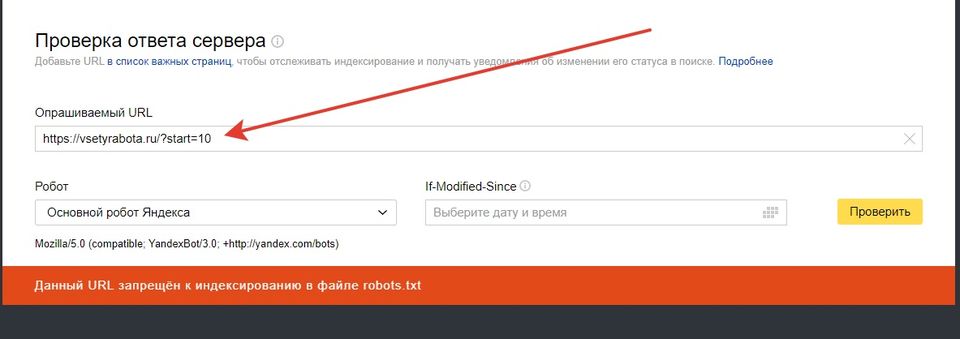

Можно выполнить проверку с помощью специальных инструментов поисковых систем. В Яндексе это инструмент для проверки ответа сервера: https://webmaster.yandex.ru/tools/server-response/

Вбив в строку «Опрашиваемый URL» проверяемый адрес, вы получите результат о том, можно ли его проиндексировать.

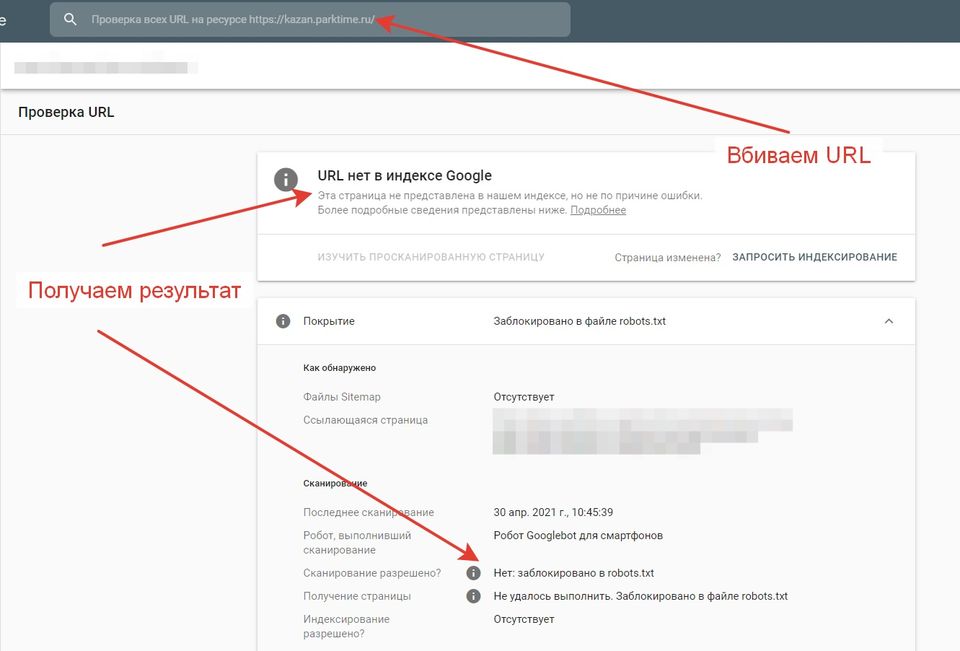

Google дает возможность проверять страницы в Search Console. Для этого достаточно вбить нужный адрес в строку «Проверка URL» и дождаться обработки результата.

На скриншоте видно, что страница отсутствует в индексе Google и ей запрещено сканирование по средствам файла robots.txt.

Основные тезисы

Есть два основных момента, которые следует помнить при запрете индексации:

- Большинство из указанных способов поисковые системы рассматривают как рекомендации и могут их игнорировать (особенно Google). По этой причине страницы могут присутствовать в индексе поисковой системы, даже если вы все сделали правильно.

- Если страница уже попала в индекс поисковой системы – потребуется определенное время (несколько дней, редко – недель) чтобы поисковые системы переиндексировали саму страницу и нашли на ней запрещающий тег. В результате страница должна пропасть из поисковой выдачи.