В 5 уроке хотелось бы рассказать о таком важном файле, который должен быть на любом сайте, как robots.txt. В этом уроке мы разберем что такое robots.txt и как создать правильный robots.txt на Joomla.

О файле robots.txt

Для начала давайте вкратце разберемся с тем, что же представляет собой файл robots.txt и для чего его нужно использовать на своем сайте. Начнем с определения:

Файл robots.txt – это текстовый файл, который расположен в корне Вашего сайта. Данный файл содержит информацию для поисковых роботов о правильной индексации страниц Вашего сайта. Здесь Вы можете, как запретить к индексации некоторые страницы, так и указать, что именно необходимо проиндексировать.

Файл необходим для правильной индексации страниц Вашего сайта. Ведь по умолчанию поисковые роботы будут индексировать все имеющиеся страницы, даже те, которые не несут смысловой нагрузки, а просто содержат некий код и бесполезны для пользователей. Чтобы избежать этого рекомендуется создавать правильный файл robots.txt. Стоит отметить, что Вы можете увидеть этот файл у любого сайта. Для этого необходимо прописать в поисковой строке адрес сайта, добавив в конце значение - robots.txt. Выглядеть это будет так?

Mysite.ru/robots.txt

Файл robots.txt на Джумле

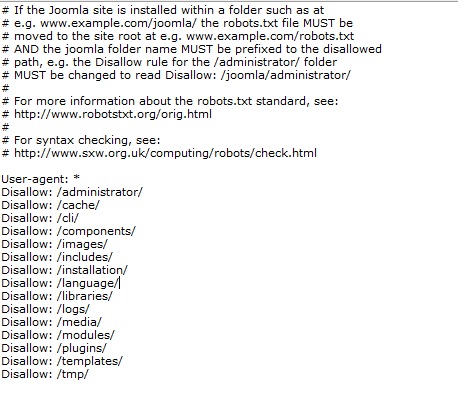

В стандартном виде файл robots.txt на Джумле выглядит следующим образом.

В данном файле разработчики Джумлы не стали запрещать к индексации страницы вывода на печать, отправить по почте и т.д. Что не очень хорошо для поисковых систем. Зато поставили запрет на индексацию папки с изображением на сайте.

Есть возможность создания отдельных директив для каждой поисковой системы. Делать это или нет зависит от конкретного сайта.

Вот в принципе так должен выглядеть файл robots.txt на Джумле. Ну и не забывайте мониторить свои страницы в панелях управления сайтом в Гугле и Яндексе. Именно там Вы можете найти страницы, которые попали в индекс. Если увидите, что поисковые боты начали индексировать какую-то директорию сайта, которая не должна быть в индексе, то просто запретите ее в robots.txt.